2024. 4. 7. 14:28ㆍ딥러닝 모델: 파이토치

♣ 활성화 함수

활성화 함수란 입력값을 어떤 값으로 변환해 출력할지 결정하는 함수를 의미함.

입력값과 가중치를 곱한 값들은 활성화 함수를 거쳐서 출력값이 됨

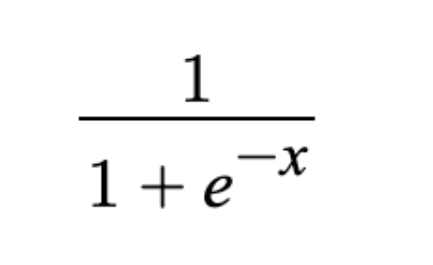

1. 시그모이드

시그모이드 함수는 입력값이 커질수록 1에 수렴하고, 작아질수록 0에 수렴함. 시그모이드 함수를 미분하면, 양쪽으로 향할수록 변화값이 거의 없음. 따라서 오류역전파를 할 때 Vanishing Gradient 현상이 발견될 수 있음.

0 또는 1을 반환하기 때문에 이진 분류 모델의 마지막 활성화 함수로 사용됨.

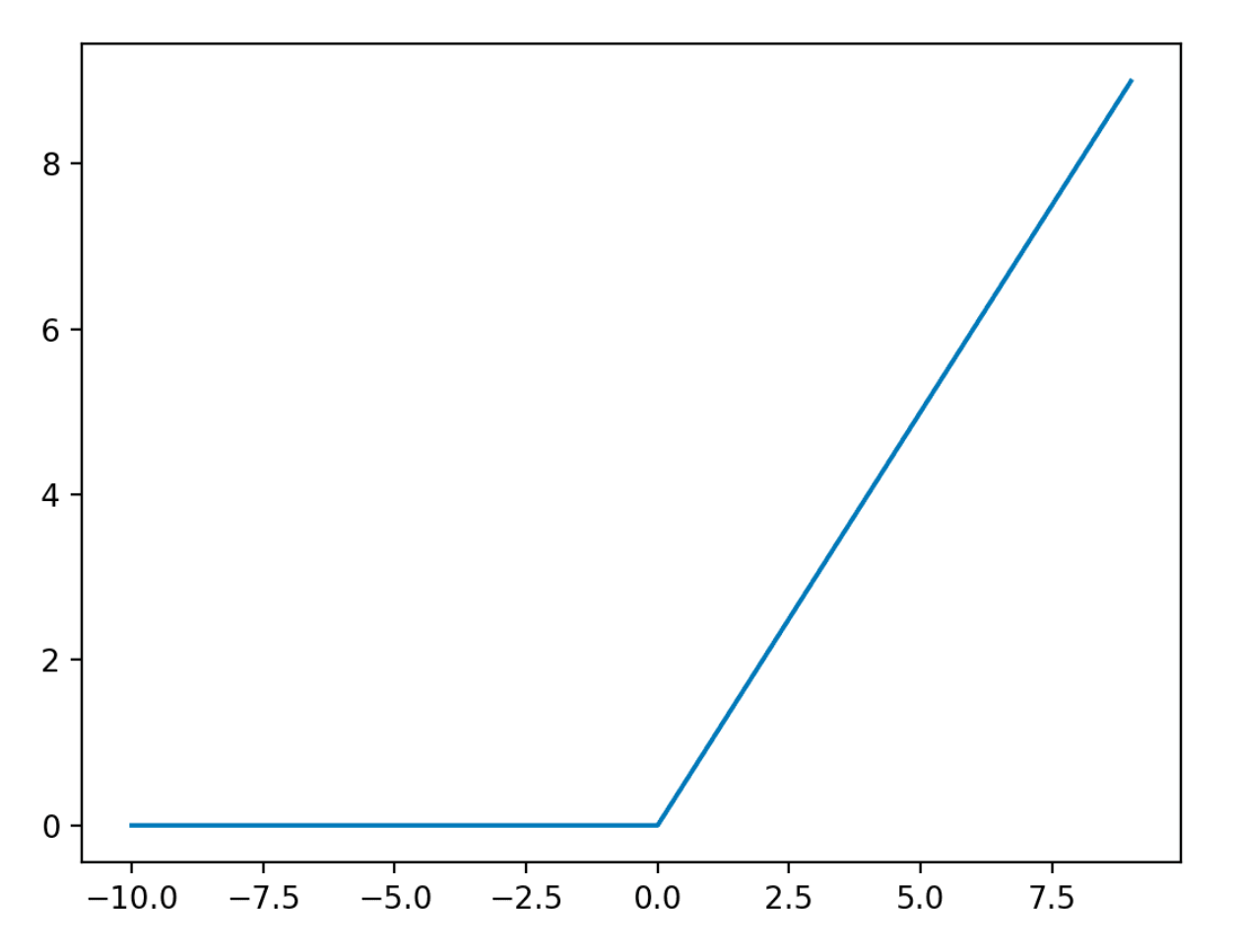

2. ReLU

ReLU 함수는 은닉층의 활성화 함수로 사용됨

입력값이 0보다 작거나 같을 때는 항상 0을 출력함.

입력값이 0보다 크면 입력값과 동일한 출력값을 출력함.

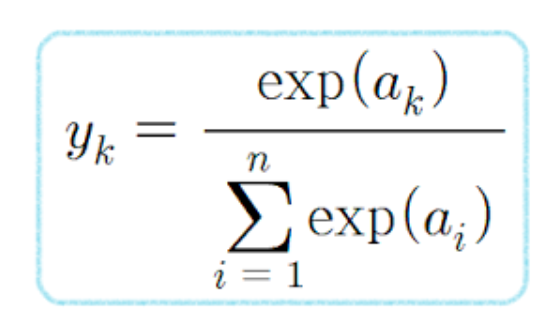

3. 소프트맥스

softmax 함수는 시그모이드와 비슷하게 0~1 사이로 변환하여 출력하지만, 출력값들의 합이 1이 되도록 하는 함수임. 따라서 다중 분류의 최종 활성화 함수로 사용됨.

♣ 참고 자료

활성화 함수

https://heytech.tistory.com/360

[Deep Learning] Activation Function 개념 및 종류: sign, tanh, sigmoid, softmax, ReLU, Leaky ReLU

📚 목차 1. 활성화 함수의 개념 2. 활성화 함수의 종류 2.1. Sign 함수 2.2. Sigmoid 함수 2.3. Tanh 함수 2.4. Softmax 함수 2.5. ReLU 함수 2.6. Leaky ReLU 함수 1. 활성화 함수의 개념 활성화 함수(Activation Function)란

heytech.tistory.com

[딥러닝] 활성화 함수 간단 정리 ! (시그모이드, 소프트맥스, ReLU)

활성화 함수 간단 정리 !!

velog.io

'딥러닝 모델: 파이토치' 카테고리의 다른 글

| Pytorch로 시작하는 딥러닝 입문(11-02. 텍스트의 유사도: Bag of Words) (0) | 2024.04.08 |

|---|---|

| Pytorch로 시작하는 딥러닝 입문(11-01. 텍스트의 유사도: 단어의 표현 방법) (0) | 2024.04.08 |

| Pytorch로 시작하는 딥러닝 입문(10-05. 펄플렉서티: perplexity, PPL) (0) | 2024.04.06 |

| Pytorch로 시작하는 딥러닝 입문(10-04. 한국어에서의 언어 모델) (0) | 2024.04.06 |

| Pytorch로 시작하는 딥러닝 입문(10-03. N-gram 언어모델) (0) | 2024.04.06 |